type

Post

status

Published

date

Sep 25, 2022

slug

dreamfields-3D

summary

我在2022年发布的应该是第一个方便好用的文生3D开源工具

tags

工具

开发

项目

编程

category

原创项目

icon

password

URL

September 25, 2022 • 7 min read

by Simon的白日梦, See original

今天的文章是在量子位对我的采访推文的基础上稍作修改写成的(作为他们的忠实读者这一波也算是梦幻联动了![Image]。

同时,先推一个今天更新的Dreamfileds-3D beta v0.6版本的demo视频,本次更新在训练过程中使用了随机相机视角(焦距),并将渲染图片经过随机处理增强之后再喂进CLIP里边求损失函数,直观上好像提升了训练的稳定性和顺带略微提升了生成质量(没有做具体的消融实验)。详细使用方法、程序链接请见以下正文哈~!

Text-to-3D!建筑学小哥自称编程菜鸟,攒了个AI作画三维版,还是彩色的

衡宇 发自 凹非寺

量子位 | 公众号 QbitAI

AI画师,技术又精进了——

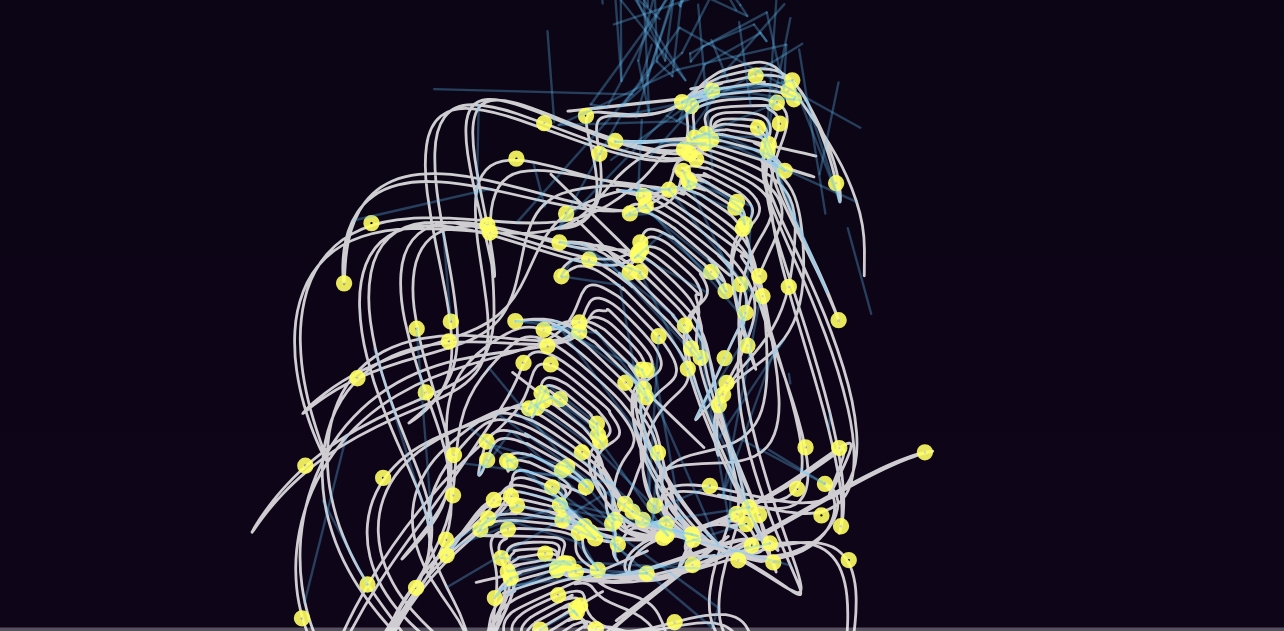

直接一句话/一张图,生成3D模型、环绕视频、NeRF实例那种。

还是带颜色的。

输入“一幅美丽的花树画,作者Chiho Aoshima,长镜头,超现实主义”,就能瞬间得到一个长这样的花树视频,nerf视频加上导出的3D模型的漫游动画,时长13秒。

这个文本/图片-3D生成AI,叫Dreamfields-3D,来自一个自称编程菜鸟的建筑学在读博士。

Demo刚被小哥放在微博、推特等平台,许多网友已经急着蹲内测了:

现在,小哥已经将它开源,colab上也能运行。

一起来上手玩玩看~

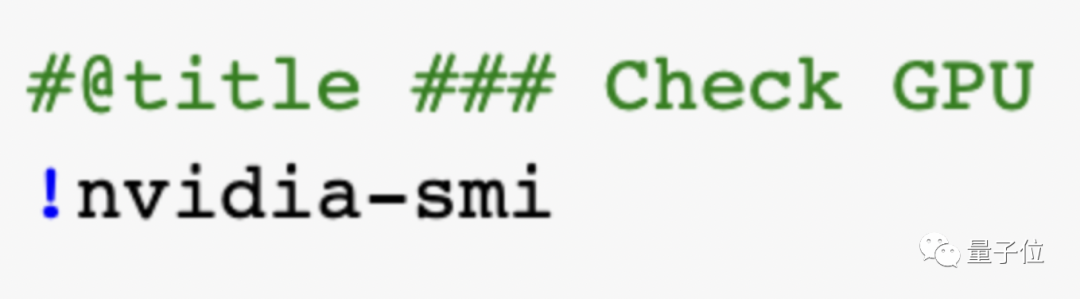

Dreamfields-3D玩法十分低门槛,大致只需要三步。这里介绍一下colab上在线玩的步骤。

首先,检查一下GPU,再挂接谷歌硬盘。

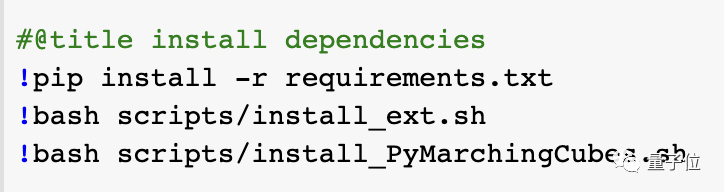

第二步,调出工具开始运行,并安装依赖项。

然后定义一些必要的功能,就可以在colab上训练和测试了~

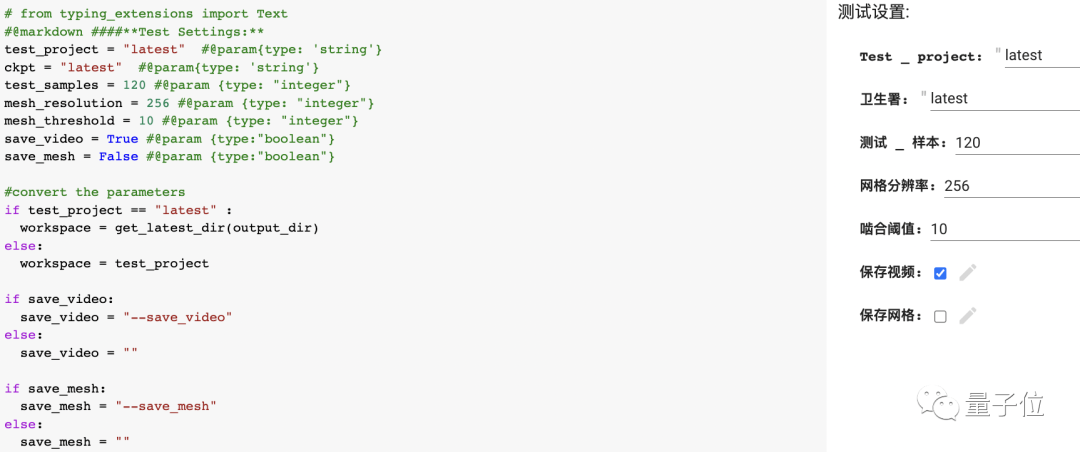

玩的时候需要输入一些参数,保存格式有视频和网格两种,输出模型格式为带顶点色的obj和ply。

万事俱备,让我们现在开始。

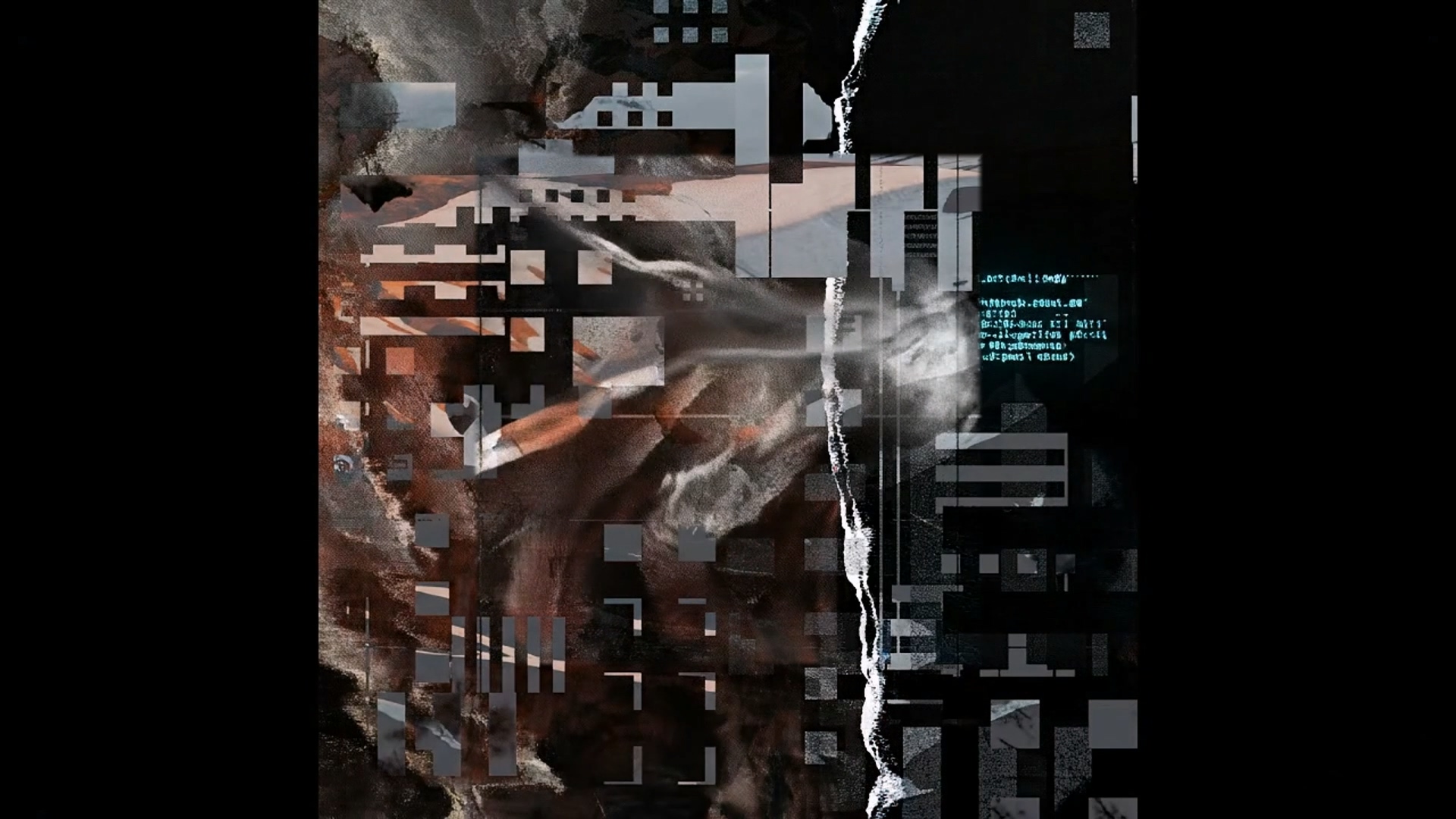

试试输入“一个赛博朋克风格的飞行霓虹灯汽车,格雷格鲁特科夫斯基和西蒙斯大林风格,长镜头,CGsociety,虚幻的引擎,史诗游戏”?

会得到一个果然很赛博的汽车的视频。

如果你是《千与千寻》重度爱好者,想搞张吉卜力风格的视频玩玩。

没问题,prompt输入“一张美丽的天空城市的插图,吉卜力工作室,艺术站,8k HD,CGsociety”,这不就来了——

有网友迫不及待上手,做出了个小计算机。

当然在鹅妹子嘤的惊叹中,也有网友表达了希望Dreamfields-3D更好的期许。

(Simon:上边这位朋友应该只是他自己没训练好!)

当然,除了文本输入,Dreamfield3D是支持图片作为prompt的。

不过现在版本还有待完善,如果输入图片,很容易造成过拟合,简单说就是如果喂它一张车的正面图,生成的3D视频中,那辆车可能4个面都是正面……

想要玩儿图片输入的友友们,怕是要再等等了。

基于现状,小哥在GitHub表达了未来的改进目标:

- 同时使用不同的CLIP模型进行训练。

- 仅在指定方向应用图像提示。未来可能要加一个图片角度的约束,例如只有在输入图片相同角度时,训练时才参考该图片。

- 作为NeRF实例读取现有三维网格,然后通过文本/图像prompt进行修改。

- 在训练中减少GPU RAM的使用。

(但小哥说了,自己是个编程菜鸟,后续可不保证哦)doge

基于谷歌Dreamfields-Torch

小哥是建筑学出身,据他讲,Dreamfield3D是他从创作者角度出发,对Dreamfield-torch做了些优化,主要的代码工作还是来自上游的Dreamfields-torch和Dreamfields。

介绍下,Dreamfields来自谷歌,它的特点是无需照片样本,简简单单一句话,就能生成3D图像,还可以生成多种物品组合成的复合结构。

在生成3D场景时,通常会选用神经辐射场(NeRF)模型方案。

NeRF的特点是可以渲染逼真的场景,但需要很多张3D照片,才能实现360°视觉重建。

相比之下,Dreamfields生成3D模型不需要照片,因为它基于NeRF 3D场景技术,利用OpenAI的CLIP跨模态模型判断文字和图片相似性的能力,通过输入的文字来引导三维模型的构建,并通过神经网络来储存3D模型。

Dreamfields-torch则是一个经过修改的Dreamfields的Pytorch实现,主要是把原Dreamfields的后端,从原始NeRF成了pytorch版的instant-ngp。

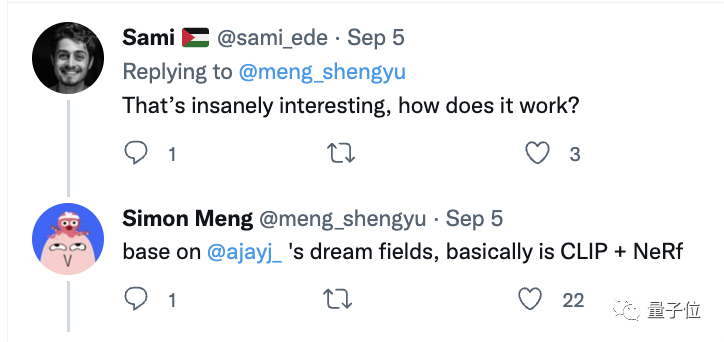

以此为基础,小哥做出的Dreamfields-3D基本上靠CLIP + NERF运作。

作者简介

作者蒙胜宇(Simon Meng),奥地利因斯布鲁克大学(UIBK)建筑学在读博士。

硕士毕业于伦敦大学学院(UCL)建筑学,现为UIBK及UCL技术课程助教及特邀评图嘉宾,从事建筑设计、艺术、AI及生物学跨领域研究。

小哥从去年6、7月份开始关注AI图像生成。

他发现,很多破圈技术,如clip guide diffusion,disco diffusion,都是一些懂代码的跨界者(艺术家)做的。

去年年末谷歌发布Dream fields,他就动了用它做3D输出的心思。

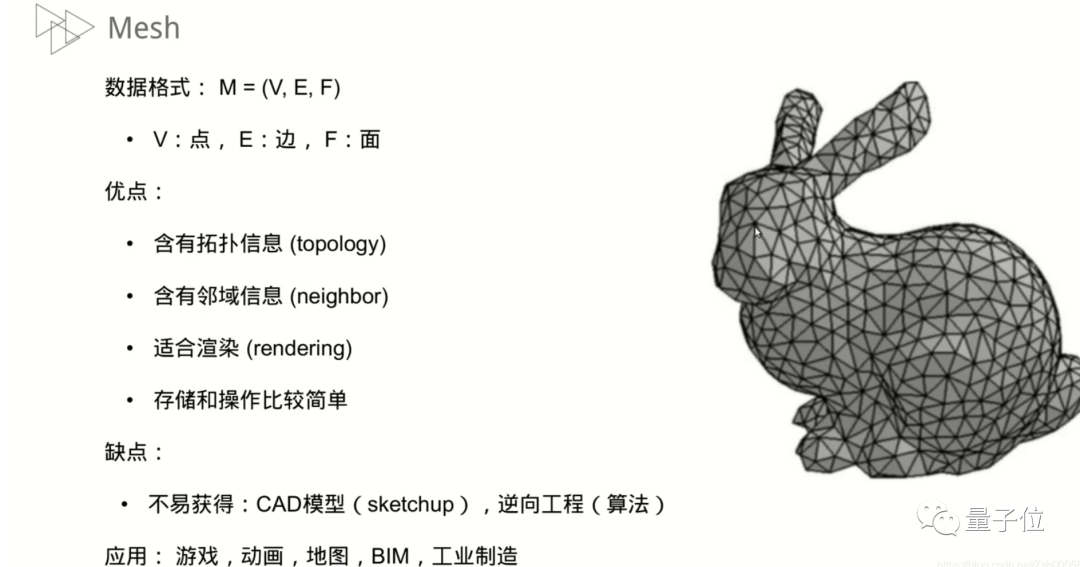

于是,在拿到动画后,他用AI做了超采样放大和插帧,然后导出帧到普通的多目重建软件(类似colmap),成功重建mesh(一个用3D模型数据还原的模型图)。

小哥把mesh发在推特上,结果Dreamfields论文的原作者Ajay Jain联系到他,表示了欢迎,还鼓励他保持优化更新——虽然那时候他用的是普通多目图片实景重建软件,不是基于代码的方法。

上个月,小哥在Dreamfield-torch的基础上做了colab版,本月在GitHub开源,让大家能够愉快地玩耍。

以及,现在这个已经是基于Marching cubes的全新版本啦~

GitHub地址:

colab地址:

参考链接:

- 作者:Simon阿蒙

- 链接:https://shengyu.me//article/dreamfields-3D

- 声明:本文采用 CC BY-NC-SA 4.0 许可协议,转载请注明出处。

相关文章