type

Post

status

Published

date

Nov 27, 2023

slug

3d-locate

summary

3D生成的问题接近解决了,那生成后3D物体的合理摆放分布就成为了新问题。

tags

工具

开发

编程

资讯

category

知识分享

icon

password

URL

November 27, 2023 • 8 min read

by Simon的白日梦, See original

前言:(全文1000字,阅读大概需要3分钟)。这篇文章会稍微涉及到一些计算机术语(不会太多),读完之后你将对基于AI的3D生成模型发展规律有一个大概的了解。

- 先说结论:最近的几个3D生成模型,都不约而同地采用了将3D模型问题简化为2D模型问题的思路。而从历史规律来说,问题的成功简化通常意味着问题的(接近)解决。

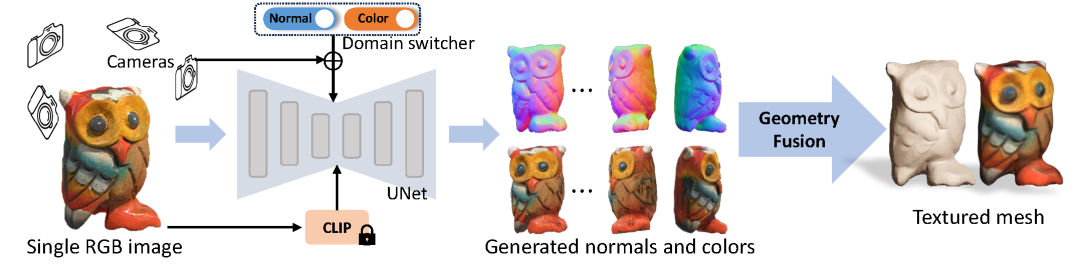

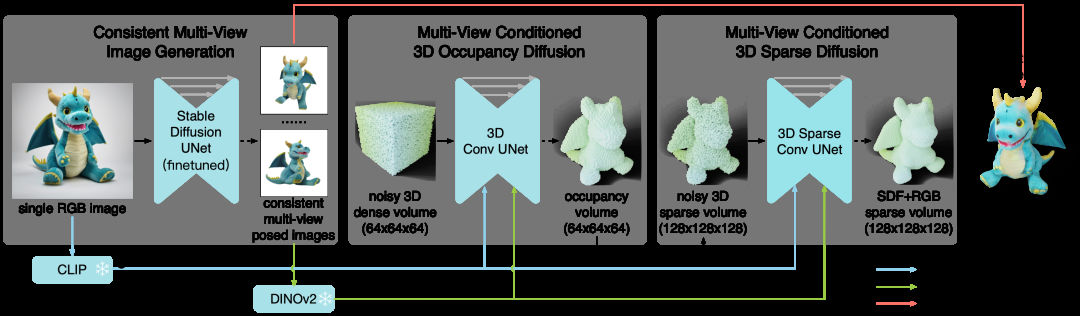

Instant3D、One-2-3-45++、Wonder3D是最近出现的几个性能更好的3D生成模型。他们的共同点是最大化地利用了2D stable diffusion模型的先验信息。

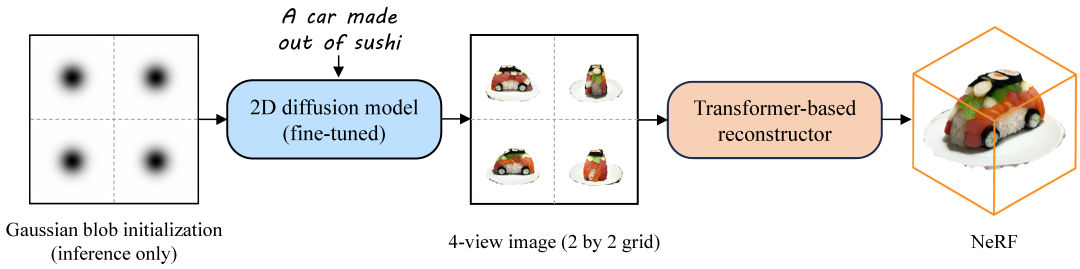

- Instant3D:使用了一个finetune的stable diffusion模型,根据输入的文字/图片生成特征连续的四视图,再用NeRF根据四视图重建3D模型。

- One-2-3-45++:类似上一个模型,使用finetune过的SD模型输入单目图像得到特征连续的多目图像,再用3D卷积神经网络+SDF重建3D模型。

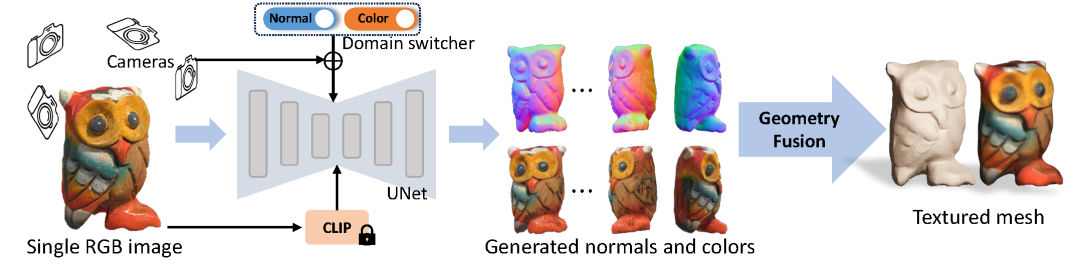

- Wonder3D: 基于stable diffusion模型finetune了一个能够同时输出特征连续的多目RGB图片和法线图的模型,最后用一个normal fusion(法线混合)模型重建3D模型。

这几个算法的共同点是速度快(单卡1-2分钟能搞定),质量还过得去,但是对比以前的3D生成算法,尤其是DreamGaussian之前的ProlificDreamer,Zero-1-to-3,DreamFusion、shap-e(但发布时间都在一年之内)之类的模型有巨大的提升(要么在速度上,要么在质量上)。

由此可见,对于2D diffusion模型的有效利用,带来了这两年3D生成模型性能的飞跃式提升。也正是由于2D diffusion模型的突破性发展,使得3D生成问题存在了简化了可能。

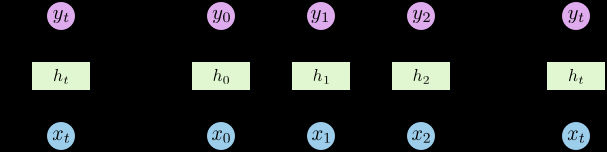

RNN循环神经网络图例

但其实这件事情也很好理解,就好像自然语言处理(NLP)这个经典任务,此前一直被尝试用复杂的基于规则的方式进行解释,例如符号学、控制论等等。后来随着循环神经网络(RNN)的出现,以及网络文字数据量的增加还有算力的提升,自然语言处理被简化成了“根据上文输入预测特定的下文出现的概率”这么一个“简单”任务,NLP任务才开始取得飞跃式发展。当然,这里所谓的简单是原理上的而非工程上的(实际上的大语言模型是一个异常复杂的工程),但是正是这种原理上的简单才使得工程上可以容纳更多的复杂性。因为结构上的可靠性提升,给了工程上更多的容错空间。

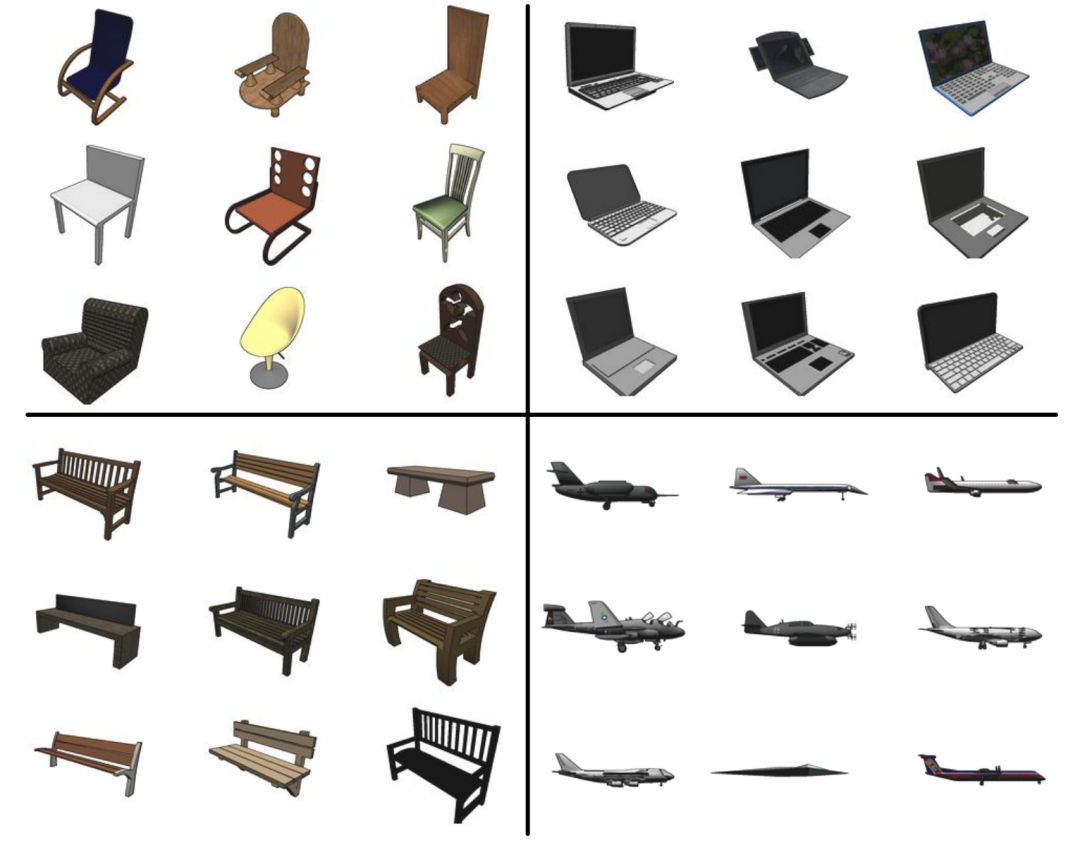

ShapeNet数据集示例

反观3D生成这边,此前的3D生成模型通常基于3D卷积神经网络(3D CNN),3D对抗神经网络 (3D GAN),或者一些复杂的3D隐式表达方法,但是效果并不尽人意。一方面是,因为大家的效果都不那么好,所以存在技术路线之争,劲没有使到一块去;另一方面则是因为3D数据库的内容缺乏:大部分模型基于ShapNet数据库进行训练,里边只有几十个分类十余万个模型,而其中最多的模型是椅子,这也是为什么以前的大多数3D生成论文都以生成椅子为demo,因为生成别的东西质量很有明显下降…… 现在虽然有了号称千万级的Objaverse-XL数据库,但是实际模型质量参差不齐,清洗后能用的或许不到百万级,更不用和动辄数十亿级的2D图文数据库做比较了。

其实,从直觉上讲,从单纯的文字输入或者单目图像输入,在有足够先验的2D模型的支持下,是能够还原足够精确的单个物体三维信息的。就好比人是能够从文字和单目图像输入去想象整个物体的完整3D形态的,因为我们见过足够多的不同物体在不同角度的2D投影,并且形成了我们的知识积累。或许也是马斯克坚定支持纯视觉方案能够解决三维环境感知和自动驾驶问题的原因之一。

因此,我愿意再次重复此前我做的判断,在2D模型能力不断增强,且大家集中火力攻关将2D模型应用到3D生成这一技术路线的情况下,单个三维物体的生成问题,在1-2两年就将得到基本解决。

但是,这里又衍生出另外一个问题——将大量不同种类的三维物体进行合乎情理,或者说顺应人类感知习惯的组合和放置,构成合理的完整三维场景。

说这个问题重要,是因为我最近的一些思考:现在3D生成模型的质量其实已经“凑合”了,为什么没有出现2D生成模型同时期(Disco diffusion时期)出现的强烈社区传播?

Disco Diffusion生成的抽象但是有趣的图像

- 我的答案有两个:第一个原因很容易想到,即三维模型的展示较为复杂,不像图片那么容易存储和显示;第二个原因则更为深层次:我们需要的其实不是2D或者3D本身,我们需要的是每一种模态给我们带来的叙事和情绪价值。

2D图像即便抽象模糊,但是每张图就是一个完整的叙事,总能给人足够的信息以及联想空间;而现在AI生成的3D模型都是孤立的,脱离环境的存在。只有3D模型被有效地整合在某个完整的环境中,才能带来叙事和情绪价值。

那么,从2D图像能够直接学习到多个3D物体的合理复杂组合么?

首先,从直觉上讲就很难,一则是同一组复杂物体组合的多视角图片数据本来就相对稀缺,二则是各个物体组合之后就会相互遮挡(甚至有些是不可见的,例如被围合在内部的),使得难以从2D图像中还原准确三维组合关系。

其次,物体的组合关系其实是一种更为抽象的节点关系,更类似蛋白质结构预测的图节点关系,而非单纯的像素间的概率关系。而这,可能是接下来AI 3D生成领域更重要的问题,也正是我们最近用自研图网络模型尝试解决的问题,如果您对我们的研究感兴趣,可以阅读以下文章:

参考文献:

_Instant3D: https://jiahao.ai/instant3d/?ref=aiartweekly_

_Wonder3D: https://www.xxlong.site/Wonder3D/_

_One-2-3-45++: https://sudo-ai-3d.github.io/One2345plus_page/_

_Objaverse:https://objaverse.allenai.org/_

_ShapeNet:https://shapenet.org/_

_RNN循环神经网络:https://zh.wikipedia.org/zh-hans/循环神经网络_

- 作者:Simon阿蒙

- 链接:https://shengyu.me//article/3d-locate

- 声明:本文采用 CC BY-NC-SA 4.0 许可协议,转载请注明出处。

相关文章