type

Page

status

Invisible

date

Jan 26, 2025

slug

summary

tags

国美

艺术

教程

category

知识分享

icon

password

URL

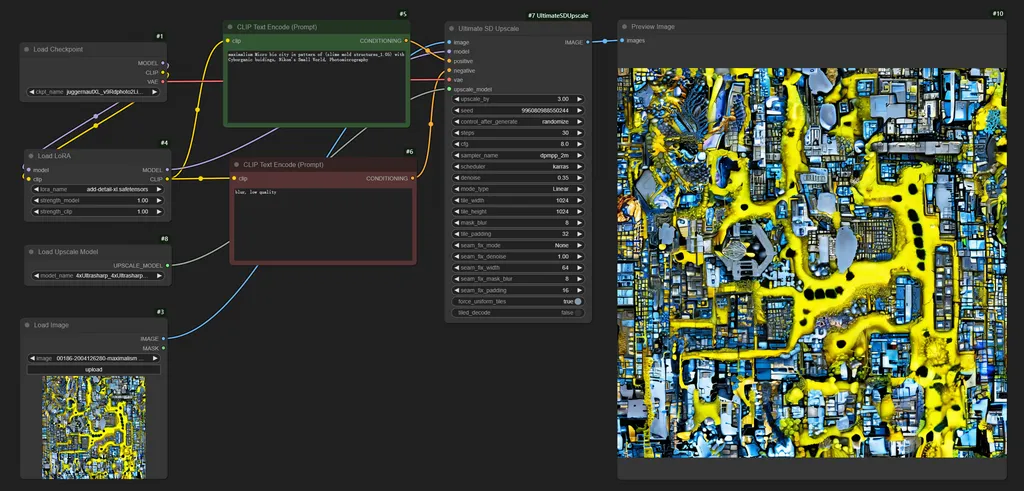

1. 使用 ComfyUI 进行图像AI超分辨率放大

改编自:Guillaume Bieler

随着 AI 工具的不断改进,图像放大已成为任何处理图像的人的必备工具。本教程将指导您如何在 ComfyUI 中使用 Stable Diffusion 构建自己的先进 AI 超分图像放大工具。

除了运行成本更低之外,这种方法与其它在线选项相比还具有一些关键优势。主要是,它提供了对工作流程的完全控制,允许您根据自己喜欢的风格和设置定制放大器。例如,您可以使用自己的 checkpoints 和 LoRAs 来引导放大器实现特定的美学效果,或者向流程中添加 controlnets 以增加从起始图像保留的细节级别。

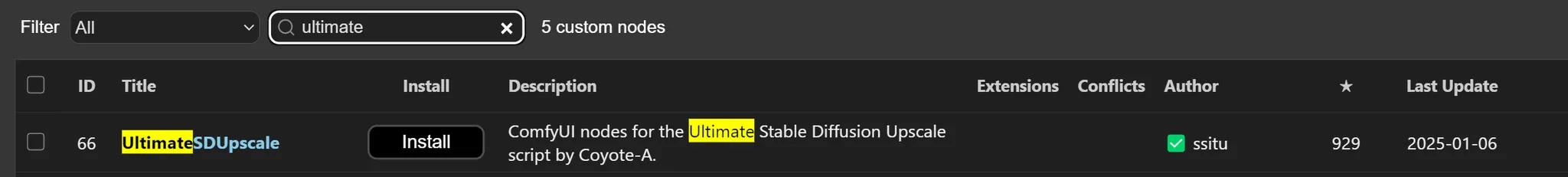

在开始之前,请确保已安装 Ultimate SD Upscale 节点包。您可以通过 ComfyUI 管理器直接安装它。

您还需要下载必要的模型才能运行工作流程:

- 您可以将 upscaler model 添加到 "ComfyUI/models/upscale_models" 文件夹。

- 将任何 SDXL checkpoint 添加到 "ComfyUI/models/checkpoints" 文件夹。在本例中,我们使用 Juggernaut XL。

- 最后,将 add detail LoRA for SDXL 添加到 "ComfyUI/models/loras"。

然后,您可以通过右键单击并下载下面的 json 文件来加载工作流程。👇

对于那些不熟悉 ComfyUI 的人来说,一开始可能会觉得可用的参数数量很多,让人望而生畏。幸运的是,您只需要知道如何使用其中几个参数就可以充分利用此工作流程。我将在此处介绍关键的参数:

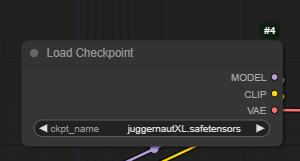

载入底模 / Load Checkpoint

这是将执行放大过程的 Stable Diffusion/SDXL 模型。我们使用 Juggernault,但您可以使用任何 SDXL 模型。

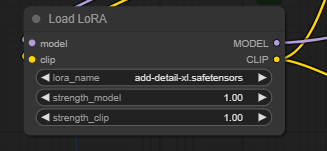

载入 Lora 风格模型

我们使用 add detail LoRA 在生成过程中创建新的细节。虽然我们建议保留此 LoRA 以获得最佳效果,但您可以使用任何 SDXL LoRA。如果您有特定的目标,还可以通过添加另一个 Load LoRA 节点来添加多个 LoRA。

strength_model 参数决定了 LoRA 的影响力。如果将其设置为 0,则 LoRA 将被完全忽略;另一方面,如果将其设置为 2,则 LoRA 将处于最强状态。

The CLIP Text Encoder (Prompt)

这两个节点是正向提示和负向提示。虽然它们对于放大图像来说不如从头生成图像那么重要,但拥有描述图像的正向提示有时可以帮助获得更好的结果。

Load Image

顾名思义,这是您上传要放大的图像的地方。

您可以从这张模糊的图片开始:

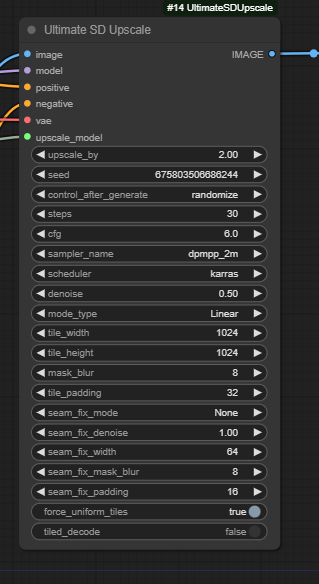

Ultimate SD Upscale

这个节点是魔法发生的地方,也是您的图像将被放大的地方。我们建议修改的唯一参数是

upscale_by 和 denoise。upscale_by 仅仅是您要将图像尺寸增加多少。它在 2 到 4 之间的值效果很好,任何更高的值都可能导致结果开始变得有点奇怪。denoise 决定了您希望给予 SDXL 模型多少创作自由度,可以取 0 到 1 之间的任何值。我们通常建议保持在 0.3 到 0.6 之间以获得更好的结果。

此工作流程适用于具有 6GB 或更高 VRAM 的 GPU。

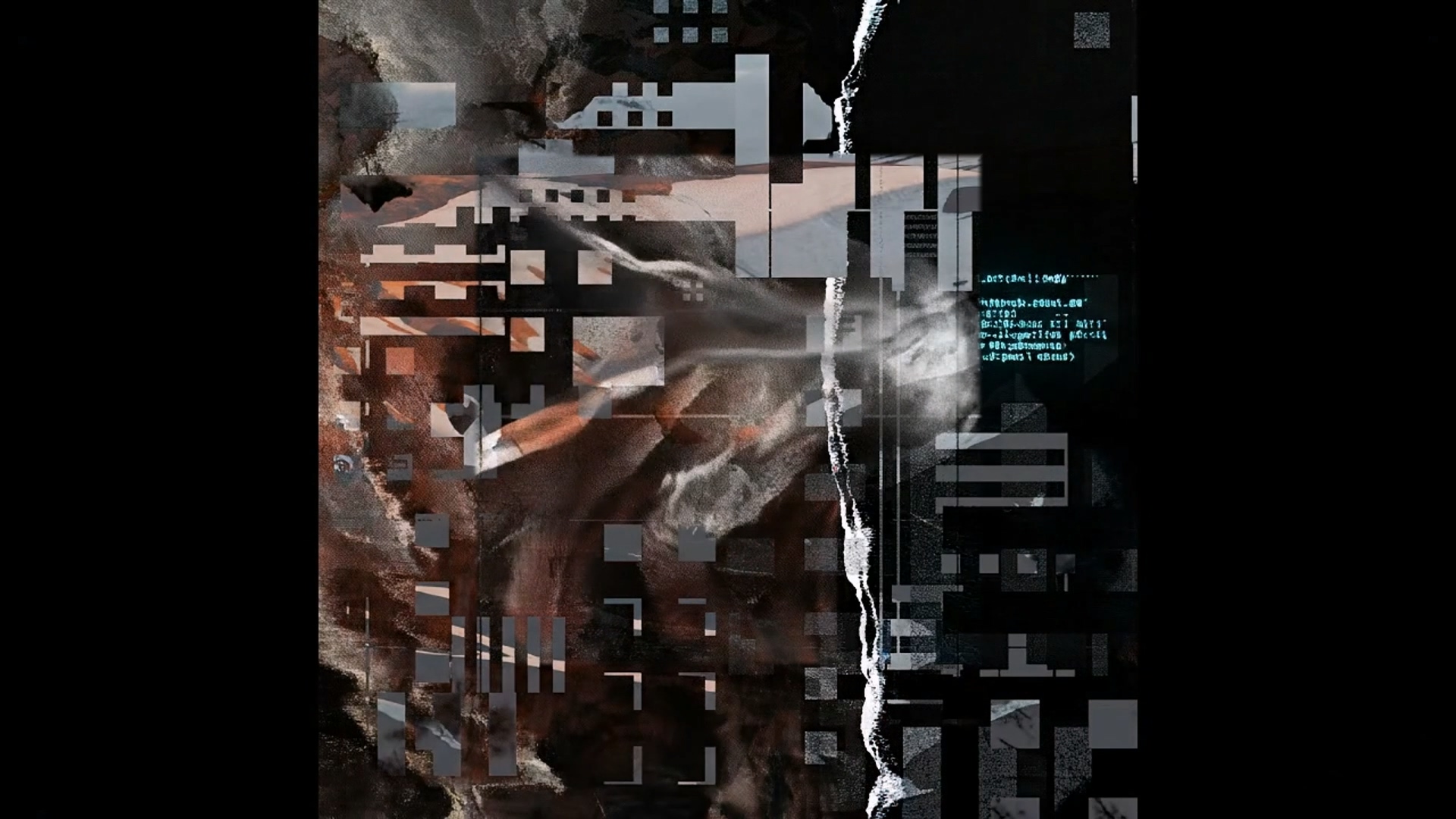

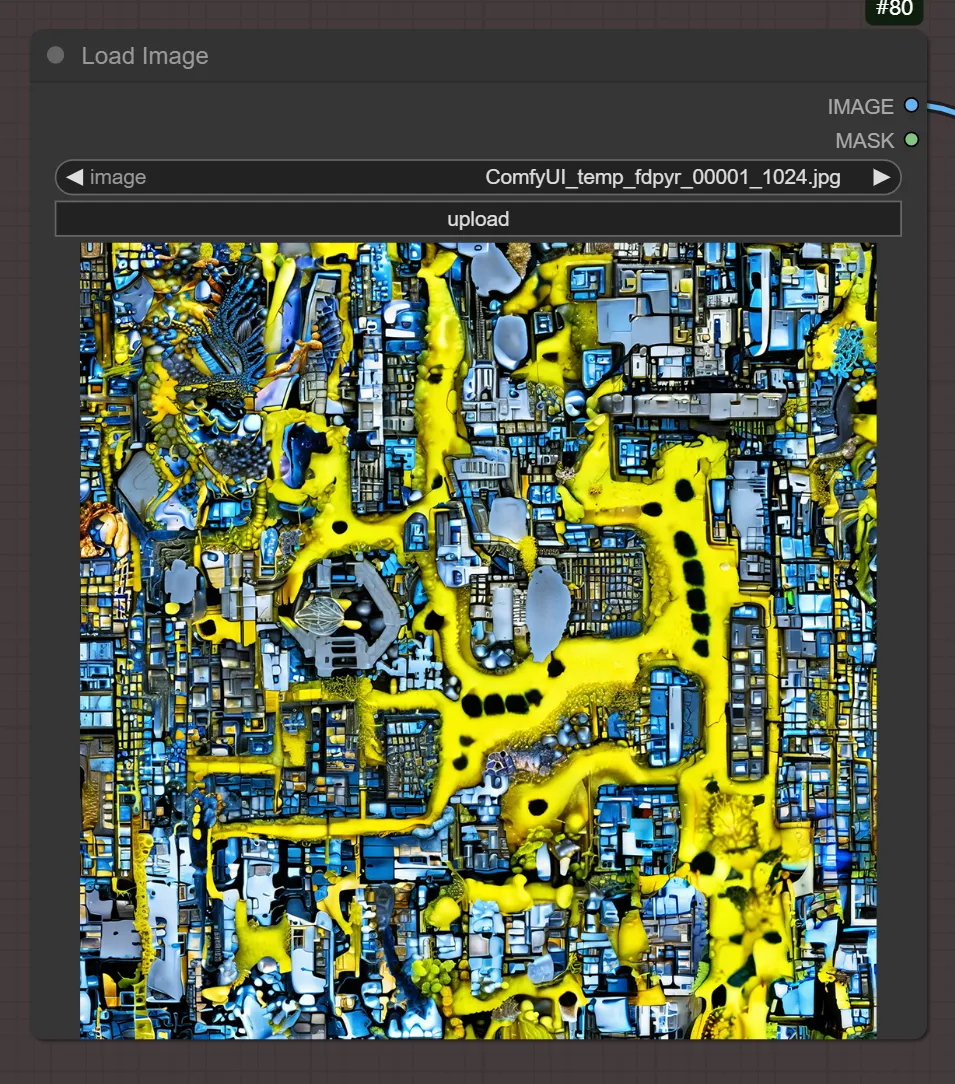

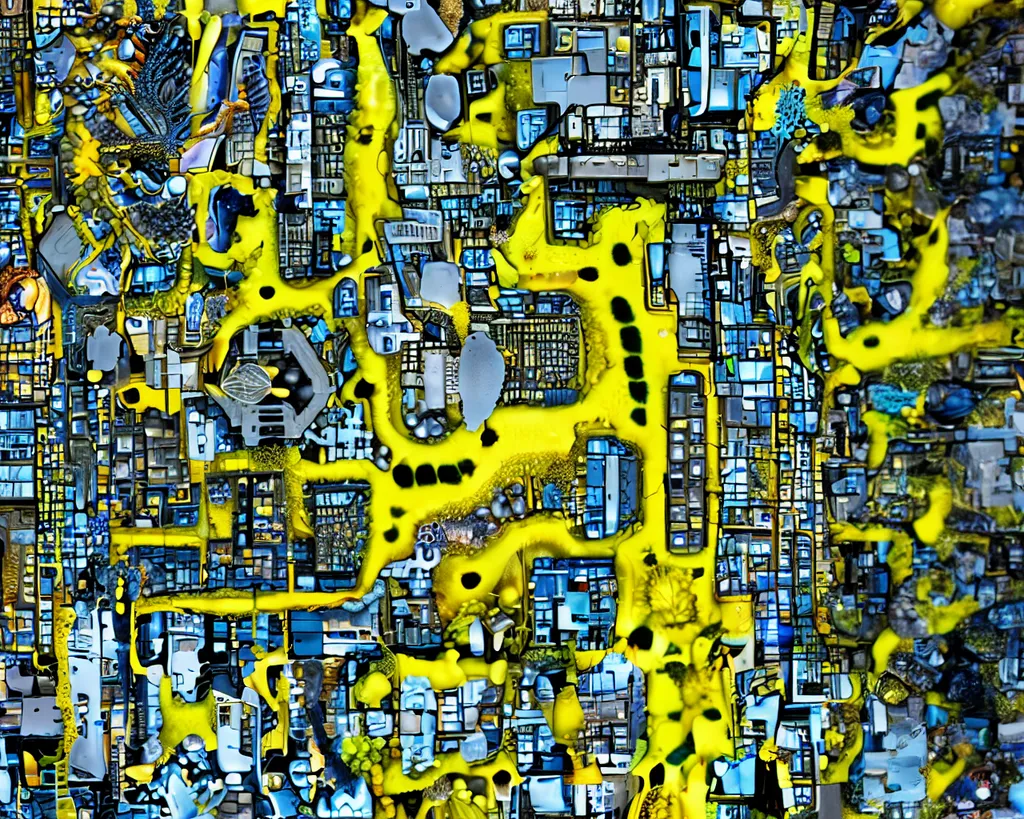

如果您成功运行所有内容,以下是结果预览。

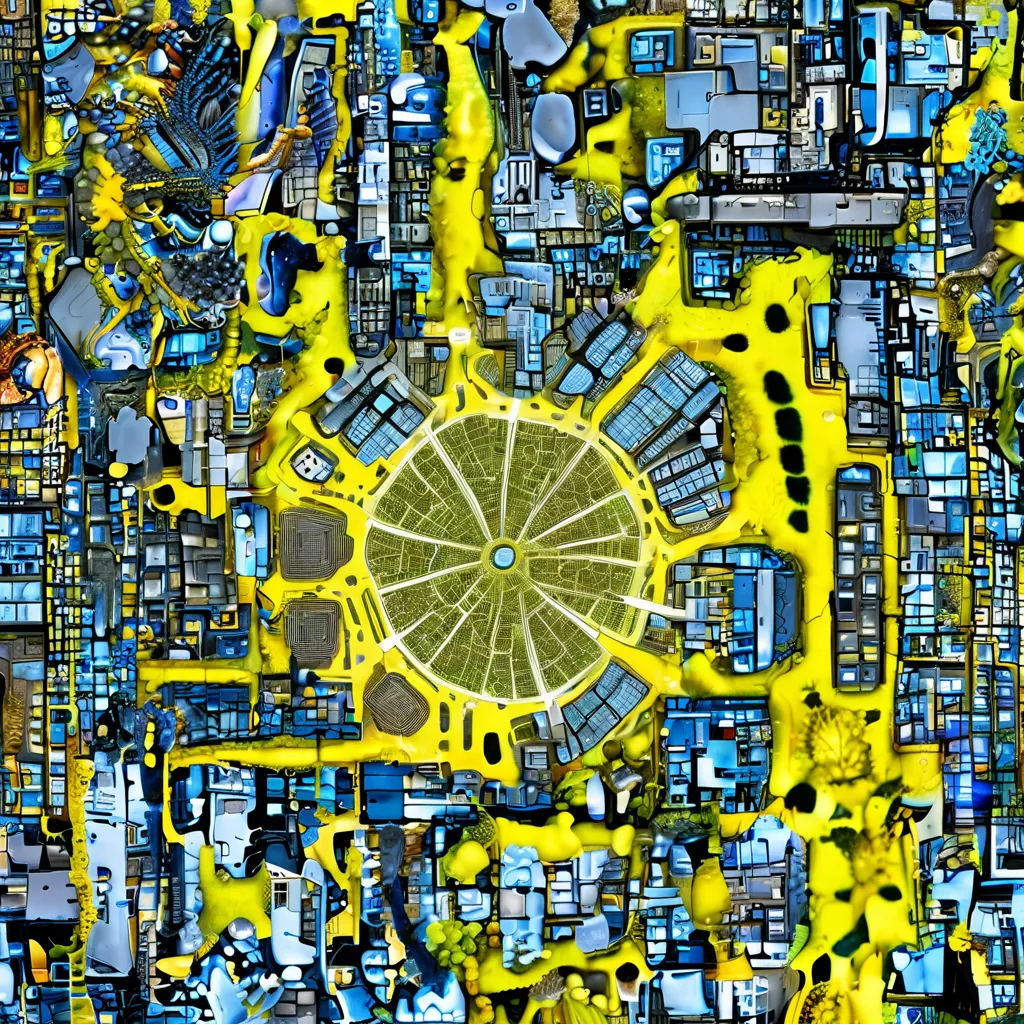

提示词:

(Satellite image view) of a maximalism bio-cyberpunk city center inside a Micro bio city in pattern of slime mold structures, plan drawing

(卫星图像视角) 下的一个极大化生物赛博朋克城市中心,位于一个具有粘菌结构模式的微型生物城市内部,平面图。

2. ComfyUI 扩图工作流

改编自:

- 扩大图像的视野

- 补充图片中缺失的部分

- 调整图像的宽高比

扩图的原理是基于 Stable Diffusion 的图像修复 (inpainting) 技术,它在图像的边缘区域添加空白区域,然后使用修复模型填充空白区域,从而扩展图像。

👇:从以下链接下载工作流程:

通过网盘分享的文件:L2-AI图像局部修改.json

链接: https://pan.baidu.com/s/1CqzFbJRr9jDFdjLSbHThAw?pwd=kks9 提取码: kks9

打开上面的链接,然后在页面中右键单击,然后单击“另存为...”。

下载后,将工作流程文件拖到 ComfyUI 中即可使用。

Stable Diffusion 模型文件

此工作流程需要使用特殊的 inpainting 模型,您也可以使用其他版本的 inpainting 模型:

模型名称 | 用途 | 仓库地址 | 下载地址 |

sd-v1-5-inpainting.ckpt | 扩图 | ||

sd-xl-inpainting.safetensors | 扩图 |

下载后,请将这两个模型文件放在以下目录中:

Path-to-your-ComfyUI/models/checkpoints

如果您想了解更多:如何安装 Checkpoints 模型 如果您想查找和使用其他模型:Stable Diffusion 模型资源

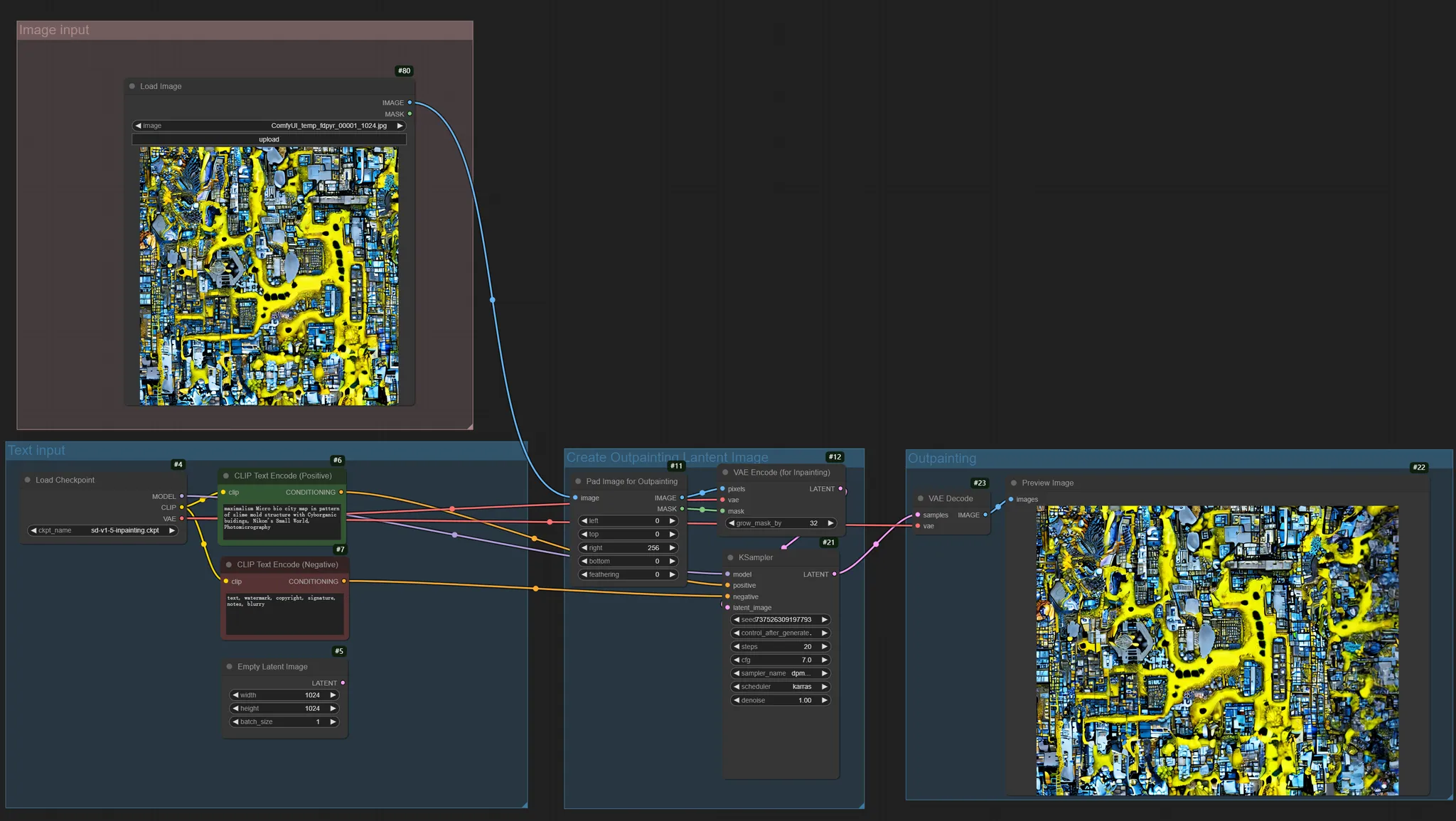

ComfyUI 基础扩图工作流使用方法

由于模型安装位置可能不同,请在工作流程中找到

Load Checkpoint,然后从模型下拉菜单中选择您下载的模型文件。- 为第一个节点选择

v1-5-pruned-emaonly.safetensors

- 为第二个节点选择

sd-v1-5-inpainting.ckpt

因为第二个节点是专门用于扩图的模型,使用该模型进行图像修复的效果会更好,您可以自行测试不同的设置。

ComfyUI 基础扩图工作流程简要说明

此工作流程分为三个主要部分:

1. 选择用于扩图的输入图像

- 设置输入图像

2. 文本输入部分

- 通过

CLIPTextEncode设置正向和负向提示。

- 使用

KSampler生成初始图像。

3. 创建用于扩图的潜空间图像 (Latent Image)

- 使用

ImagePadForOutpaint节点在原始图像周围添加空白区域。

- 节点的参数决定了图像将在哪个方向上扩展。

- 同时,将为后续的扩图生成相应的遮罩 (mask)。

4. 扩图生成

- 使用专用的图像修复 (inpainting) 模型进行扩图。

- 保持与原始图像相同的提示,以确保风格一致。

- 使用

KSampler生成扩展区域。

使用说明

- 调整扩展区域:

- 在

ImagePadForOutpaint节点中设置四个方向的扩展像素值。 - 数字表示在该方向上要扩展的像素数。

- 提示设置:

- 正向提示描述您想要的场景和风格。

- 负向提示有助于避免不需要的元素。

- 模型选择:

- 在第一阶段使用常规的 SD 模型。

- 建议在扩图阶段使用专用的 inpainting 模型。

ComfyUI 基础扩图工作流程注意事项

- 进行扩图时,尽量保持提示的连贯性,以便扩展区域和原始图像能够更好地融合。

- 如果扩图效果不理想,您可以:

- 调整采样步数 (sampling steps) 和 CFG Scale。

- 尝试不同的采样器 (samplers)。

- 微调提示。

- 推荐的扩图模型:

- sd-v1-5-inpainting. Ckpt

- 其他专用的 inpainting 模型

3. ComfyUI 局部修图工作流

改编自 Prompting Pixels

使用 ComfyUI 进行图像修复不像其他应用程序那样简单直接。但是,您可以通过几种方法来解决此问题。在本指南中,我将介绍一个基本的图像修复工作流程和一个依赖于 ControlNet 的工作流程。

您可以在此处下载工作流程👇

基础图像修复工作流程

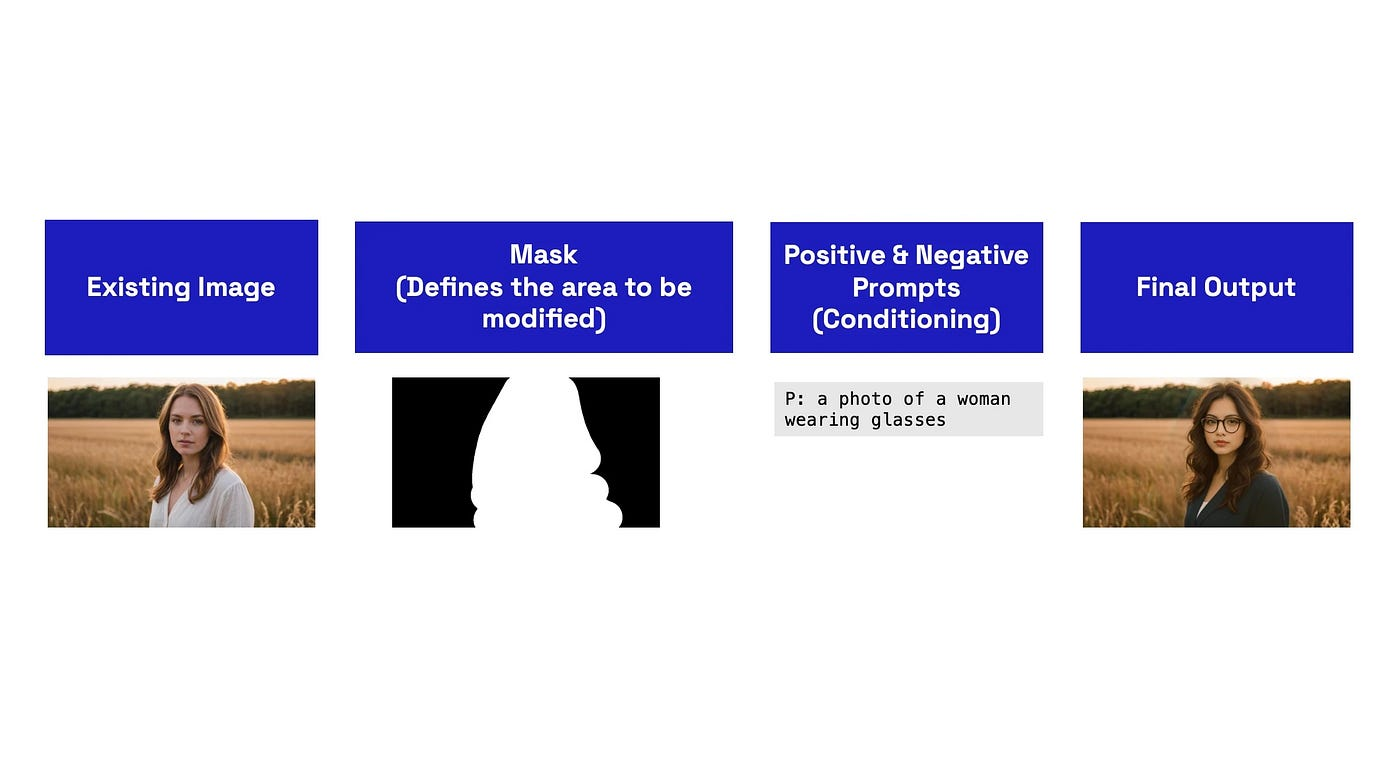

图像修复是图像到图像 (image-to-image) 和文本到图像 (text-to-image) 过程的混合。我们采用现有图像(image-to-image),并仅修改其一部分(遮罩),在潜空间 (latent space) 内,然后使用文本提示(text-to-image)来修改并生成新的输出。

这是一个图表,其中涉及了值得注意的步骤:

我将解释工作流程中的每个核心概念。

注意:您应该为此过程使用 inpainting 模型。这些模型与标准生成模型有根本的不同,因为它们是在部分图像上训练的。

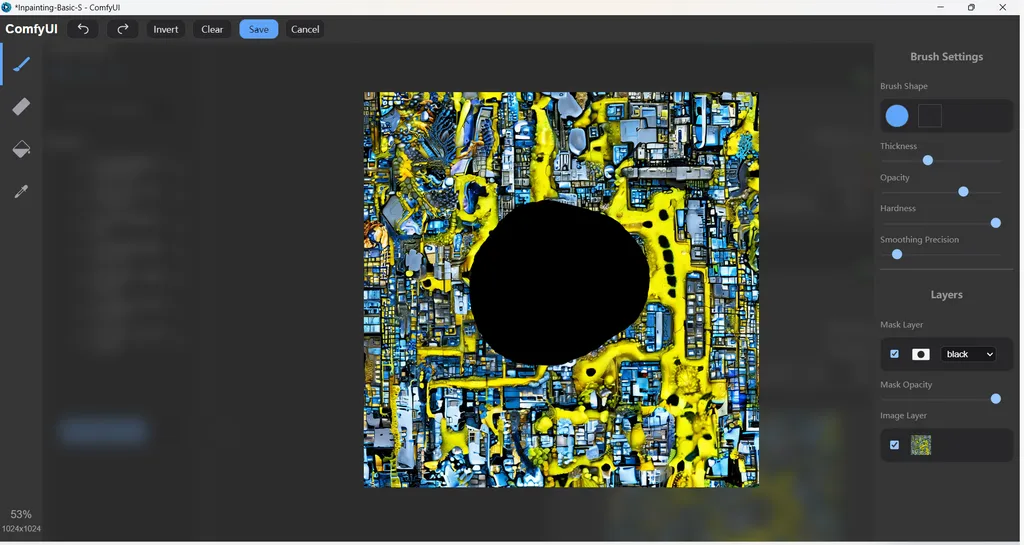

1. 加载图像和 MaskEditor

在 ComfyUI 的 Load Image 节点中,有 MaskEditor 选项:

这为您提供了一个基本的画笔,您可以使用它来遮罩/选择要修改的图像部分。

- 您可以使用此图像进行测试。

- 右键单击以打开 MaskEditor

设置好遮罩后,您只需单击“Save”选项。这将在 ComfyUI 中的

input/clipspace目录下创建输入图像的副本。 专业提示: 遮罩本质上会擦除或创建图像中的透明区域(alpha 通道)。除了使用 MaskEditor,您还可以上传您可能在其他照片编辑应用程序中创建的遮罩/部分擦除的图像。

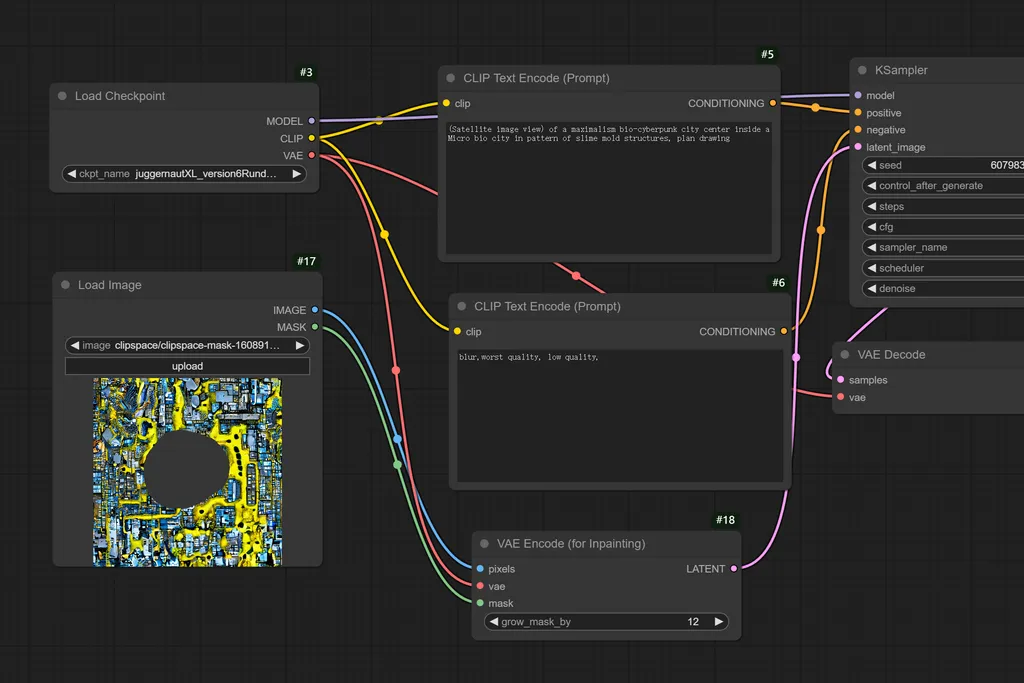

2. 编码遮罩图像

原始图像以及遮罩部分必须传递到

**VAE Encode (for Inpainting)** 节点 - 可以在 Add Node > Latent > Inpaint > VAE Encode (for Inpainting) 菜单中找到。然后,您将图像和遮罩以及来自您的模型或来自单独 VAE 的 VAE 传递给此节点:

设置会向遮罩添加填充,为模型提供更多的工作空间,并提供更好的结果。您可以在

。在大多数情况下,默认值 6 很好,但可以增加到 64。

此节点会将您的图像和遮罩转换为潜空间表示。这使模型能够理解图像并根据您的文本提示和 KSampler 设置生成新的输出。

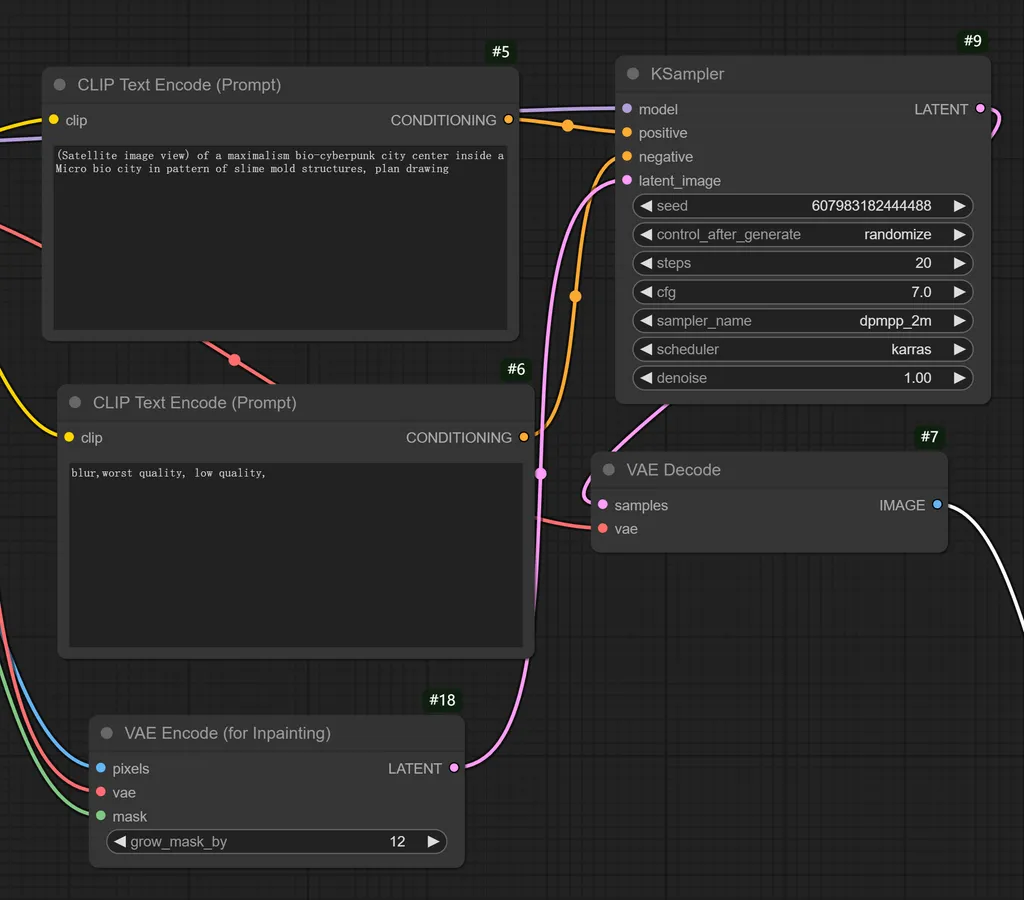

3. 文本提示和 KSampler

您的正向和负向文本提示有两个目的:

- 它通常描述图像的内容(可选但建议使用)。

- 它为模型在生成输出时提供了一个方向。

至于 KSampler 设置,这将取决于所使用的模型。因此,请检查模型卡以获取最佳设置。

至于 KSampler 中的 denoise,与其他应用程序(如 Automatic1111 WebUI、Forge 等)不同,较低的 denoise 水平不会保留原始图像。

相反,它只会暴露遮罩。因此,请将其保持在 1.0。

提示:在 KSampler 中使用固定的 seed 值而不是随机值最好,因为您可以复制或迭代相同的图像和遮罩。如果您很难正确设置提示或输出,这尤其有用。

4. 解码并查看输出

最后,您只需通过

VAE Decode 节点解码图像,然后查看或保存输出。这是我们的示例结果: